Uma equipe de pesquisadores da Áustria e dos Estados Unidos provou que dirigir é uma tarefa mais fácil do que parece. O grupo desenvolveu um sistema de inteligência artificial neuromórfico que imita o funcionamento do sistema nervoso de animais como minhocas e lombrigas e resolveu testá-lo em um carro autônomo. E, para a surpresa de todos, o sistema obteve um desempenho positivo.

Essa não é a primeira vez que a equipe apresenta uma proposta ousada. Afinal, o trabalho é um melhoramento de outro sistema, apresentado em 2018, que estacionou um pequeno robô usando apenas 12 neurônios.

A equipe afirma que sistemas mais simples apresentam vantagens sobre os modelos de aprendizado de máquina atuais. Isso porque eles lidam melhor com entradas cheias de ruído e, devido à sua baixa complexidade, o modo de operação pode ser explicado em detalhes — dispensando a “caixa preta” da inteligência artificial.

Pexels/Reprodução

Pexels/Reprodução Sistema comanda carro autônomo

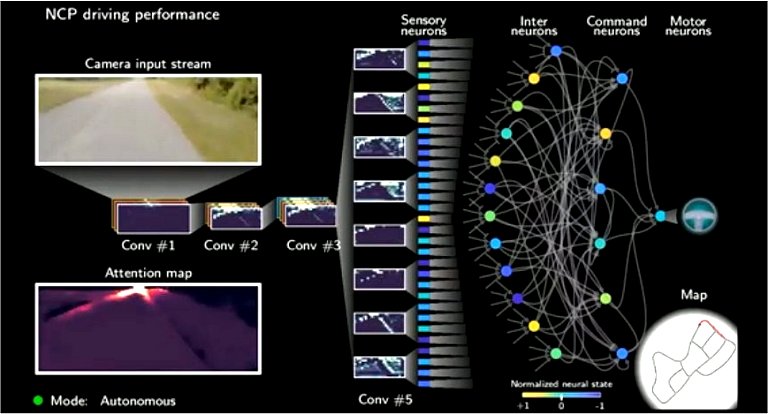

Com somente 19 neurônios, o sistema coletou imagens de motoristas humanos dirigindo em ambientes urbanos. Esses dados foram processadas por uma rede neural convolucional, que seleciona as partes mais importantes das imagens e envia os sinais para um sistema de controle que dirige o veículo.

Para que o sistema dirigisse de forma independente, até mesmo em situações inesperadas, ele foi ensinado a conectar automaticamente as imagens com o movimento do volante. Antes de colocar o projeto à prova, a rede neural e o sistema foram “empilhados” e treinados simultaneamente com horas de vídeos de trânsito, registrado por um carro que rodou a área metropolitana de Boston.

Inovação Tecnológica/Reprodução

Inovação Tecnológica/Reprodução “Nosso modelo nos permitiu investigar no que a rede foca sua atenção enquanto dirige. Nossas redes se concentram em partes muito específicas da imagem da câmera: O meio-fio e o horizonte. Esse comportamento é altamente desejável e é único entre os sistemas de inteligência artificial,” disse o pesquisador Ramin Hasani, da Universidade de Tecnologia de Viena, na Áustria. “Alcançar esse grau de interpretabilidade é impossível para modelos de aprendizado profundo maiores”, finalizou.

Source link